Aus dem Internet-Observatorium #71

KI-Regulierung - neue Fragen / Internet-Blackout in Gaza (und anderswo)

Hallo zu einer neuen Ausgabe - etwas verspätet, der Tagesjob fordert seinen Tribut. Und an dieser Stelle verspreche ich: Für den nächsten Newsletter bemühe ich mich ein Titelthema zu finden, das nichts mit KI zu tun hat.

KI-Regulierung - neue Fragen

In den vergangenen Tagen gab es einige Entwicklungen und Debatten, hier der Versuch eines Überblicks mit den wichtigsten KI-Fragen.

Behindert Bidens Executive Order Startups?

So argumentiert zumindest Steven Sinofsky von Andreessen Horowitz und erhält dabei einige Zustimmung. Unter anderem wird auf die Meldepflichten für besonders große Transformer-Modelle und bestimmte Rechenzentren verwiesen (siehe Ausgabe #70).

Was richtig ist: Compliance ist eine Königsdisziplin für Firmen, die bereits im Geschäft sind. Nicht für Startups. Und ja, es gibt durchaus eine Vielzahl von Ansprechpartnern in der Regierung, die genannt werden. Aber bei genauerem Hinsehen habe ich keine konkreten Voraussetzungen gesehen (z.B. Größe von Sicherheitsteams o.ä.), die ich jetzt als riesige Hürde sehen würde. Allerdings stehen Detailregeln natürlich noch aus.

Mir scheint die Kritik eher aus der Analogie zur bisherigen Hardware- und Software-Entwicklung zu kommen. Aus dieser Perspektive ist das natürlich alles viel zu viel. Aber es gibt eben auch gute Gründe, die KI-Branche in bestimmten Bereichen eher wie die Flugbranche, Chemieindustrie oder sonstige Risiko-Branchen zu betrachten, in denen bestimmte Sicherheitsregulierungen vorgenommen werden.

Und selbst wenn es nicht so ist: Die Einführung von Fahrzeug-Standards wie Licht, TÜV oder Airbag haben nicht unbedingt dazu geführt, dass plötzlich nichts mehr Neues entwickelt wurde.

Regulieren wir die richtigen Dinge?

Die Widersprüche hier wurden beim AI Safety Summit in Großbritannien deutlich: In Überschriften und manchem Beitrag ging es darum, dass man katastrophale Risiken für die Menschheit durch den Kontrollverlust über KI adressieren möchte.

Gleichzeitig wurde sehr konkret über Alltagsfragen wie Diskriminierung, synthetischen Content oder Intransparenz geredet, die keinen zivilisatorischen Schaden anrichten, aber eben Personengruppen oder Bereichen oder schlicht dem Einzelnen schaden (Politico hat eine gute Zusammenfassung).

Wer das hier aufmerksam liest, weiß, dass ich diese Dichotomie für seltsam halte. Es gibt kein “entweder, oder” bei den Risiken, mit denen es umzugehen gilt. Es muss letztlich beides adressiert werden. Aber ich neige dazu, der Einschätzung zuzustimmen, dass der Fokus auf existenzielle Risiken den größeren Playern sicher ganz recht ist (wobei ich nicht sagen würde, dass das alles nur Taktik ist).

Was wird aus Open-Source-Modellen?

Bidens Erlass legt fest, dass das Handelsministerium innerhalb von 270 Tagen Regeln für den Umgang mit Open-Source-Modellen entwickeln soll. Allerdings heißt es dort auch, wie The Information beschreibt (übersetzt und gefettet):

“Ein anderer Abschnitt der Exekutivverordnung besagt, dass Modellentwickler Informationen über “das Eigentum und den Besitz der Modellgewichte” von Grundmodellen sowie “die physischen und Cybersicherheitsmaßnahmen zum Schutz dieser Modellgewichte” mit der Regierung teilen müssen. (Mit “Gewichten” sind hier die “Einstellungen” eines Modells gemeint.) Es ist hier nicht ganz klar, ob diese Regelung auch für Unternehmen gilt, die Open-Source-Modelle entwickeln, aber wenn ja, könnte das Probleme für sie bedeuten, da sie definitionsgemäß die Gewichte ihrer Modelle öffentlich zugänglich machen.”

Der Umgang mit Open-Source-Modellen ist der vielleicht wichtigste Faktor, wenn es um die künftige Richtung der KI-Landschaft geht. Denn einerseits liegt hier ein mögliches regulatorisches Dunkelfeld, zumal, wenn Open-Source-Modelle weiterentwickelt und für ungute Dinge trainiert werden. Und Dunkelfelder wären natürlich problematisch, wenn wir von existenziellen Risiken reden.

Andererseits liegen im Open-Source-Bereich auch die größten Chancen für ein möglichst breit gefächertes und innovatives KI-Ökosystem, in dem es nicht zu Oligopolbildungen und Abhängigkeiten von einzelnen Anbietern kommt. In eine ähnliche Richtung argumentiert ja die von Mozilla angeführte Initiative.

Tendenziell scheint mir derzeit auch die Gefahr zu bestehen, im Wunsch nach Regulierung Open-Source-Modelle zu beschränken. Und damit einerseits dem Wettbewerb zu schaden, andererseits letztlich bei dem Versuch zu landen, Wasser in einen Sieb zu gießen. Denn die ersten Modelle sind in der Welt und im Zweifelsfall nutzen gibt es ja auch Open-Source-Modell aus anderen Weltregionen, zum Beispiel den Golfstaaten.

Baut OpenAI die erste echte KI-Plattform?

Wahrscheinlich ja. OpenAI hat in der Keynote diese Woche einige Pläne vorgestellt, die in diese Richtung gehen (Zusammenfassungen bei Ben Thompson und The Verge). Der vielleicht wichtigsten Punkt: Die Möglichkeit für Entwickler, eigene “GPTs” zu entwickeln. OpenAI-CEO Sam Altman:

“GPTs sind maßgeschneiderte Versionen von ChatGPT für einen spezifischen Zweck. Sie können einen GPT erstellen – eine angepasste Version von ChatGPT – für fast alles, mit Anweisungen, erweitertem Wissen und Aktionen, und dann können Sie ihn veröffentlichen, damit andere ihn nutzen können. Und weil sie Anweisungen, erweitertes Wissen und Aktionen kombinieren, können sie Ihnen nützlicher sein.”

Das Ganze kann man dann in einem App-Store respektive “GPT Store” von OpenAI der Kundschaft anbieten. Ob das funktioniert, hängt maßgeblich von der Qualität der Software ab - daran entscheidet sich, ob der “GPT Store” ein echter App-Store oder eher ein Drehkreuz für user-generated Bots wird.

Casey Newton schreibt über die Strategie:

“[OpenAI] strebt danach, die KI-Brücke zwischen allen Arten von Online-Diensten zu werden, sie von den glorifizierten Textern, die sie heute sind, in echte virtuelle Assistenten, Trainer, Tutoren, Anwälte, Krankenpfleger, Buchhalter und mehr zu verwandeln. Der Weg dorthin wird bessere Modelle, Produkte, Richtlinien und wahrscheinlich auch einige Regulierungen erfordern. Aber die Vision liegt klar erkennbar vor uns.”

Das ist kein kleiner Aufschlag. Allerdings gibt es noch verschiedene andere Formen, zur Plattform für KI zu werden. Zum Beispiel fungieren Poe (h/t Marcel Weiss) oder Huggingface bereits als Aggregatoren. Und dann haben wir ja auch noch absehbar eine vertikale Spezialisierung in den (fast) unendlich vielen Feldern und Branchen, in denen KI eine Rolle spielen wird.

P.S.: Ich habe am Wochenende im Deutschlandfunk die aktuellen Entwicklungen in der KI-Regulierung kommentiert. Ein unterschätzter Punkt: Bidens Executive Order wird mittels Aufträgen eine Menge Staatsgeld in die einheimische KI-Branche pumpen. Eine Form von Wirtschaftsförderung, die wir in Europa und speziell in Deutschland (anders als Subventionen) viel zu wenig nutzen, gerade im Bereich Software.

Internet-Blackout in Gaza (und anderswo)

Am Sonntag gingen in Gaza zum dritten Mal Internet, Mobilfunk und Festnetz-Telefonie aus. Das heißt: Wer auf diese Weise kommunizieren wollte, musste entweder Geld für ein Satelliten-Telefon oder für Satelliten-Internet haben. Oder mit einer israelischen oder ägyptischen SIM-Karte so nahe an der entsprechenden Grenze sein, dass das Signal dorthin reichte.

Der Blackout betraft nicht nur Einheimische, sondern auch Hilfsorganisationen. Ende Oktober hatte Elon Musk für solche Organisationen Starlink-Verbindungen angeboten, allerdings wurde das bislang nicht weiter verfolgt. Israels Regierung hatte den Vorschlag kritisiert. Das Verteidigungsministerium äußert sich nicht über die Verantwortung für die Blackouts, allerdings ist das Netz in Gaza maßgeblich von israelischer Infrastruktur abhängig - und der Blackout in Sonntag ging mit Luftangriffen einher.

Soweit die Fakten. Ich erwähne das einerseits, weil es eine digitale Komponente des Nahost-Kriegs zeigt. Und weil das Thema Internet-Blockaden in den vergangenen Jahren viel zu wenig Aufmerksamkeit bekommen hat. Leider auch hier.

So wird zum Beispiel das Internet in der Konfliktregion Tigray seit drei Jahren blockiert. Die Blockade durch die äthiopische Regierung führte in Kombination mit physischen Einreisesperren dazu, dass der Krieg dort quasi unter Ausschluss der Öffentlichkeit stattfand. Was zur Folge hat, dass die offenbar zahlreichen äthiopischen Kriegsverbrechen in der Region wahrscheinlich niemals nachgewiesen werden können. Im von Bürgerkriegen geplagten Darfur ist die Telekommunikation ebenfalls seit fünf Monaten unterbrochen. Und Irans Regime nutzt regelmäßige Blackouts, um die Koordination von Protesten zu unterbinden.

Das sind nur einige der Beispiele. Der Krieg in Gaza steht buchstäblich im Fokus der Weltöffentlichkeit. Insofern ist eine digitale Dauer-Blockade nicht möglich, selbst wenn das israelische Militär sie in Betracht ziehen würde. In anderen, abgelegenen Regionen dagegen sind sie ein politisches Werkzeug, das ohne Hemmungen für repressive Zwecke genutzt wird.

Modis Stimmklon-Strategie

Surreal anmutendes Stück von Nilesh Christopher über “AI Modi”. Indiens Premier Narendra Modi lässt im Lichte der Wahlen im kommenden Jahr seine Stimme synthetisieren, also klonen. Und diese Stimme ist Teil einer Viralkampagne, bei der “AI Modi” gerade Volkslieder aus allen Regionen des Landes singt, und zwar in den jeweiligen örtlichen Sprachen. Zitat (übersetzt):

“Aber die Videos, obwohl sie heiter sind, dienen einem größeren politischen Zweck in Indien, einem Land mit 22 Amtssprachen. Modis Reden auf Hindi können oft für große Teile der Bevölkerung unzugänglich sein, die die Sprache nicht verstehen. Stimmklonung könnte hier helfen, Kampagnen zugänglich zu machen, erzählte der politische Stratege Sagar Vishnoi. KI-Stimmklonung könnte diese Sprachbarriere in Indien abbauen, insbesondere die sprachliche Nord-Süd-Kluft, sagte er. "KI könnte entscheidend für die Wahlen 2024 sein."“

Longreads zu Sam Bankman-Fried

Vor fast genau einem Jahr hatte ich über Sam Bankman-Fried und den anbrechenden Kryptowinter geschrieben. Vergangene Woche hat ein Geschworenengericht den FTX-Migründer nun in allen Punkten schuldig gesprochen. Ich hatte überhaupt keine Zeit, den Prozess zu verfolgen, will aber etwas zu dem Meta-Thema etwas empfehlen: Der Frage, ob die Biografie “Going Infinite”, die Beststeller-Autor Michael Lewis über SBF geschrieben hat, zu naiv an die Sache rangeht.

Weil mir die fast einhellige Kritik daran in vielen Medien teilweise eindimensional erschien, will ich hier zwei Gegenpositionen verlinken. Hier argumentiert Cody Kommers ganz nachvollziehbar (und ausführlich), warum “Going Infinite” sein Versprechen einlöst und letztlich genau wie Lewis’ andere Bücher funktioniert.

Und in der London Review of Books setzt sich John Lanchester auf gelungene Weise mit Lewis’ Biografie, aber auch mit SBFs Verhältnis zum effektiven Altruismus auseinander. Sein Fazit (übersetzt und gefettet):

“Ich sehe keinen Widerspruch zwischen der Person, die in "Going Infinite" beschrieben wird, und den Vorwürfen gegen SBF. Tatsächlich denke ich, dass das Buch es uns leichter macht zu verstehen, wie und warum er das tat, was ihm vorgeworfen wird. Ich kann mir leicht vorstellen, dass SBF bestimmte Taten mit Blick auf ihre erwartete Rendite sah und dementsprechend handelte.

Wenn er eine 50-prozentige Chance hätte, 100 Milliarden Dollar zu verdienen, um sie zu spenden und sie mit einer 50-prozentigen Chance vergleichen würde, erwischt zu werden, alles zu verlieren und für den Rest seines Lebens ins Gefängnis wandern, hätte er nicht gezögert. Denn die mögliche Rendite dieser Wette wäre 50 Milliarden Dollar, und in seinem Wertesystem wäre es unethisch, diese Wette nicht einzugehen.”

Lanchester beschreibt Bankman-Fried nach der Buchlektüre als Charakter, der sein nicht-existentes Betriebssystem mit dem Wertekanon der Effective-Altruism-Bewegung ersetzt. Ein Mann ohne Eigenschaften im 21. Jahrhundert also - nicht im Musil’schen, wohl aber im Wortsinn.

Links

Verstößt YouTubes Adblocker-Erkennung gegen EU-Datenschutzrecht?

Fortschritte bei der Regulierung militärischer KI.

Spotify bezahlt Künstler nur noch ab 1000 Streams - was das bedeutet.

Nostalgie-Rekord bei Fortnite.

Google hat ein Problem mit Falschinfo-Content. ($)

DeepFake-Nacktbilder werden an Schulen ein Problem (sicher nicht nur in den USA).

Threema-Chef Blatter ist skeptisch, was die EU-Interoperabilität von Messengern angeht.

X/Twitter, das entstehende Betriebssystem für Desinformation

Meta setzt bei WhatsApp auf den Ausbau von Channels und in Indien zeigt sich, wie die Monetarisierung funktionieren könnte.

Doch kein KI-Zögerer: Elon Musk stellt KI-Chatbot “Grok” vor

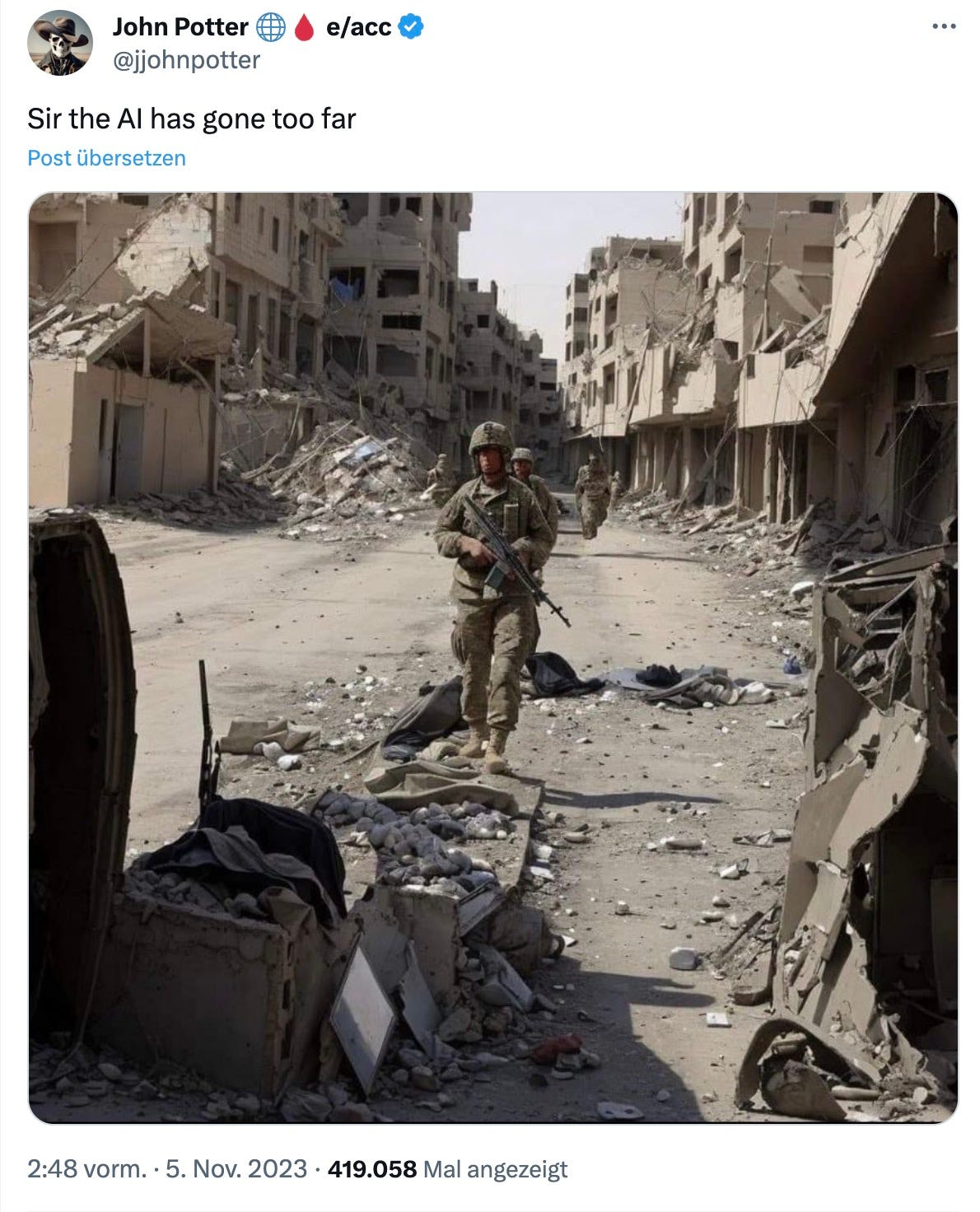

Ein Tweet

Dieses Bild bitte mit halbgeschlossenen Augen angucken, wie wir es von den üblichen 3-D-Bildern kennen. Nichts zu sehen? Die Auflösung gibt es bei Ryan Broderick (und hier hinter dem Klick). Das Tool dafür findet sich hier.

Bis zur nächsten Ausgabe!

Johannes