Aus dem Internet-Observatorium #55

A.I. Trump vs. A.I. Biden / LLMs und die verstopften Arterien des Web / "AI Act" in Tabellen

Hallo zu einer neuen Ausgabe! Die exzessive Berichterstattung über die Idee eines Cagefights Zuckerberg vs. Musk signalisiert, dass wir uns in rasender Geschwindigkeit dem Sommerloch nähern. Mein Wunsch für die Ferienmonate: Bitte, bitte keine Denkstücke mehr über Maskulinität im Silicon Valley / unter Tech-Milliardären. Danke!

A.I. Trump vs. A.I. Biden

Rund um die Uhr debattieren (A.I.) Trump vs. (A.I.) Biden bei Twitch. Beziehungsweise beschimpfen sich gegenseitig sowie die Nutzer, die im Chat Fragen stellen können.

Der Stream von TrumporBiden2024 ist ein guter Gradmesser für die aktuelle Baseline bei synthetischem Content (“DeepFakes”): Die beiden Kandidaten wirken auf den ersten Blick durchaus realistisch. Eine Voraussetzung dafür ist der statische, verschwommene Hintergrund. Und auch wenn die Lippenbewegungen noch nicht völlig passen: der Audio-Output ist absolut realitätsnah. Bei längerem Angucken merkt man allerdings, dass es sich um Segmente handelt, beide wirken durch die kurzen Zuckungen wie Androiden.

Verblüfft bin ich allerdings vom Content: Der Gamer-Humor der beiden ist durchaus an Konzepten aus der Welt da draußen orientiert und durch die Einspeisungen der Nutzer zu einem gewissen Grad interaktiv. Ich gebe zu: Ich habe vergangene Woche häufiger mal eingeschaltet und auch kommentiert, weil ich das Schauspiel derart faszinierend fand.

Ich will aber noch auf den kulturellen Kontext eingehen. Der Twitch-Kanal ist auch deshalb eine gelungene Parodie auf die amerikanischen TV-Wahldebatten, weil das verbale Schlammcatchen des Formats schlicht auf die Spitze getrieben wird. Trolling ist der beste Content, Content ist alles und politisch ist im Kern nur Leere.

Das ist als Parodie witzig. Aber Trolling ist als politische Strategie derart verbreitet, besonders bei der radikalen politischen Rechten, dass mir das Lächeln bisweilen im Gesicht gefriert. Denn ich würde behaupten, dass von den beiden vorpolitischen Netzkultur-Vibes der frühen 2010er-Jahre nicht Tumblr, sondern 4Chan den politischen Diskursraum erobert hat. TrumporBiden2024 ist deshalb auch nur eine Parodie - für eine Groteske liefert der Channel etwas zu viel wiedererkennbare Gegenwart.

LLMs und die verstopften Arterien des Web

Eine neue Woche, eine neue Abkürzung: UAIN steht für “Unreliable Artificial Intelligence-Generated News websites” - also KI-gespeiste Content-Farmen. Das Tool Newsguard misst seit Anfang Mai, wie sich das UAIN-Ökosytem im Web entwickelt und kommt auf erstaunliche Zahlen: 1200 UAIN-Artikel gehen jeden Tag online, jede Woche entstehen 25 neue Content-Farmen dieser Art. Und der Trick funktioniert: Programmatic Advertising funktioniert - auch mit Google, das solche Resultate eigentlich downranken will - bestens.

James Vincent von The Verge nimmt das zum Anlass, über die Bedeutung von KI-Content für das Web nachzudenken. tl;dr: Die Arterien des alten Webs werden immer stärker von Müll verstopft, doch im Sterbeprozess ist noch nicht abzusehen, wie das “neue Web” aussehen könnte. Und

ergänzt das Ganze um Überlegungen, was passieren wird, wenn LLMs nicht anhand von menschlichem Content lernen, sondern LLM-generierten Content konsumieren (tl;dr: nichts Gutes, siehe auch “Model Collapse”).Mein Problem mit beiden Artikeln: Das menschgemachte Web wird darin etwas idealisiert dargestellt. So als wäre alles hinter dem https://www. stets Wikipedia- oder Archiv-würdig. Dabei sind viele Inhalte schon lange generisch (wegen SEO) und selbst Bereich Social auf Datenbank-Dynamiken optimiert (wegen Fame/Clout).

Damit will ich das Problem des “verschmutzten Feedback-Loops” nicht kleinreden. Ich selbst vertrete ja die These, dass uns das neue Zeitalter des synthetischen Contents immer mehr kognitive Kapazität abverlangen wird - und das gilt auch für den Text-Output großer Sprachmodelle. Aber die Umwelt, in der die KIs bislang online lernen konnten, war bereits verschmutzt. Der Unterschied ist, dass diese Verschmutzung qua Masse industrielles Ausmaß hatte, aber nun automatisiert hochskaliert werden kann.

Eigentlich wären hier zwei Akteure gefragt: Google, das von der Suche bis zum eigenen KI-Assistenzsystem als Anbieter von Lösungen gefragt wäre. Leider wird die Suche aber (zumindest meiner Wahrnehmung nach) immer schlechter und ist nicht so weit weg von Content-Verschmutzung.

Der zweite Akteur wären die Sozialen Netzwerke, wo personalisiert Gewichtungen und Validierungen von Informationen stattfinden könnten. Allerdings macht hier die Aufmerksamkeitsökonomie der Suche nach “Wahrheit” einen Strich durch die Rechnung. So existiert für LLMs auch ein besonderer Wert in Reddit, das sich den Mechanismen entzieht und so für viele Informationen zu einer sehr brauchbaren (Lern-)Quelle wurde.

Und irgendwo dort könnte auch der Weg liegen, auf dem das “neue Web” liegt: Menschliche Quellen als präferierte Fixpunkte im Informationssystem. Diese Quellen von den Maschinen unterscheidbar zu machen, ist eine zentrale Aufgabe; die andere liegt vielleicht darin, menschlichem Content eine Form von Wert zu geben, der über Aufmerksamkeit und Auffindbarkeit hinaus geht. Womit wir dann wieder von einer ganz neuen Seite bei den Prinzipien von web3/Web 3.0 ankommen.

Der AI Act in Tabellen

Um mir einen Überblick zu verschaffen, habe ich Chat-GPT verschiedene Artikel zum “AI Act” gefüttert. Hier die unterschiedlichen Schwerpunkte und Perspektiven von Europäischem Rat und Europaparlament (die auf dem Vorschlag der EU-Kommission aufbauen, der aber inzwischen entsprechend veraltet ist).

Ich glaube, das Bild wird recht klar: Die EU-Länder sehen KI eher im Kontext Wettbewerb und halten den Einsatz auch in sicherheitspolitischen Feldern für geboten. Das Europaparlament versucht, genau solche Anwendungen (Live-Biometrie, Predictive Policing) explizit auszuschließen - und versucht die “Ganz-oder-gar-nicht"-Hochrisikoklassifizierung durch neue Voraussetzungen (Schäden für Gesundheit, Sicherheit, Grundrechte oder Umwelt) etwas praxisnäher zu gestalten. Und die Foundation Models sollen ebenfalls mit Transparenz- und Risikobewertungspflichten separat eingeordnet werden, zudem muss ihr synthetischer Output als solcher erkennbar sein.

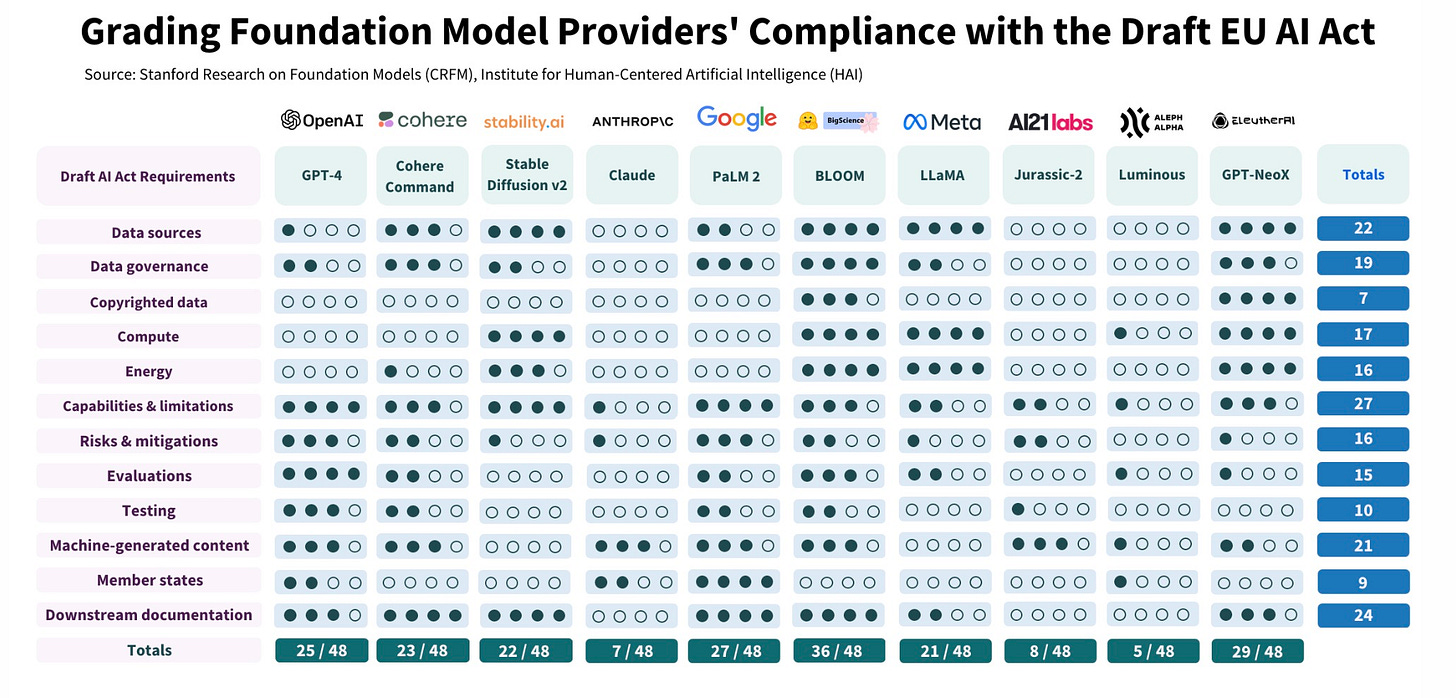

Und hier noch eine weitere Tabelle - die stammt aber nicht von mir, sondern vom stammt vom Stanford Center for Research on Foundation Models. Dort hat man sich die Transparenzpflichten angesehen, die sich für Foundation Models ergeben:

Hier zeigt sich, dass es eine ganze Reihe von Dokumentationspflichten gibt - z.B. Downstream, also die API-Nutzung, aber auch Urheberrechtsfragen bei verwendeten Daten oder auch der Energieverbrauch des Trainings.

Allerdings wird hier auch noch etwas anderes sichtbar: Das ganze Regulierungsmodell verschiebt sich bei Open-Source-Modellen (z.B. GPT-NeoX). Denn da ist die Transparenz bei Daten- und Rechenkraft-Verwendung wahrscheinlich höher, die Verbreitung und Downstream-Nutzung dagegen zentral nicht ohne Weiteres festzustellen.

Links

Die EU-Institutionen haben sich auf den “Data Act” geeinigt.

Die (jetzt verabschiedete) E-Evidence-Verordnung im Datenschutz-Konfliktfeld EU & USA.

Goodreads hat ein Problem mit Review-Bombing. ($)

Data-Labeling und die Arbeitsbedingungen.

Wie man gegen Falschinformationen vorgehen sollte - und wie nicht.

Was würde passieren, wenn der Datentransfer von der EU in die USA wirklich verboten werden würde?

Warum es so schwierig ist, die Folgen von LLM auf die Jobwelt zu prognostizieren.

Social Media und die fragmentierte Zukunft.

Wie wird der digitale Euro funktionieren?

Vibe Shift (eine literarische Ko-Autorenschaft)

Geldstrafen für die “KI-Anwälte”.

Bis zur nächsten Ausgabe!

Johannes