Aus dem Internet-Observatorium #47

Google & AI - die schiefe Bahn / Der blinde Wettlauf / Chatbots und das UI-Problem

Hallo zu einer neuen Ausgabe! Eine ernstgemeinte Frage: Kann jemand von euch/ihnen einen seriösen Kurs für Prompt Engineering empfehlen? Hinweise gerne per Mail, in den Kommentaren oder auf Twitter.

Google & AI - die schiefe Bahn

Alphabet-Chef Sundar Pichai Ende März zur New York Times:

“I’ve thought about A.I. for a long time, and we are definitely working with technology which is going to be incredibly beneficial, but clearly has the potential to cause harm in a deep way. And so I think it’s very important that we are all responsible in how we approach it.”

Ein typischer PR-Textbaustein, aber zumindest mit der Botschaft: Wir brechen das nicht übers Knie.

Zwei Wochen später am 16. April meldet die New York Times dann: Samsung hat angedroht, auf seinen Geräten die Google-Standardsuche durch Bing (mit seiner ChatGPT-Integration) zu ersetzen. Woraufhin Google sich entschlossen habe, die KI-Integration in die Suche vorzuziehen. Was kann schon schiefgehen, das Kernprodukt in beschleunigter Deadline mit einer Technologie zu erweitern, die zum Fabulieren von Informationen tendiert?

Auch die Medienoffensive Geoffrey Hintons lässt zumindest vermuten, dass Google ohne stabiles Geländer arbeitet. Hinton hat einiges für die Anwendung neuronaler Netze geleistet und fast ein Jahrzehnt für Google im Machine-Learning-Bereich gearbeitet. Sein Fazit, jetzt nach seinem Ausscheiden:

“Until last year, he said, Google acted as a “proper steward” for the technology, careful not to release something that might cause harm. But now that Microsoft has augmented its Bing search engine with a chatbot — challenging Google’s core business — Google is racing to deploy the same kind of technology. The tech giants are locked in a competition that might be impossible to stop, Dr. Hinton said.”

Der blinde Wettlauf

Tech-Giganten, die in einem Wettbewerb gefangen sind, der sich nicht mehr unterbinden lässt: Was Hinton sagt, zieht sich derzeit durch die Entwicklung. Dieses Interview von

mit OpenAI-Gründer Sam Altman verdeutlicht das. So sagt Altman über Künstliche allgemeine Intelligenz, also den Menschen einholende oder übertreffende Intelligenz:“I think the development of artificial general intelligence, or AGI, should be a government project, not a private company project, in the spirit of something like the Manhattan Project. I really do believe that. But given that I don’t think our government is going to do a competent job of that anytime soon, it is far better for us to go do that than just wait for the Chinese government to go do it.”

Mal abgesehen davon, dass ich die AGI-Debatten derzeit für Ablenkung halte: Die Argumentation von Altman ist insofern interessant, als er sagt a) eigentlich müsste das in der Verantwortung der Regierung liegen, aber b) leider ist die unfähig dazu weshalb wir es c) dann doch selber machen, weil sonst die Chinesen ihre eigene AGI entwickeln.

In dieser Logik gibt es gar keine Alternative dazu, dem Machbaren auch zur Existenz zur verhelfen. Die Verantwortung wird der Unaufhaltsamkeit des Fortschritts zugewiesen. Das ist… ziemlich unerwachsen (Ein Eindruck von Altman, den man schon in den Profilen vom März gewinnen konnte).

LLMs und der Arbeitskampf in Hollywood

Aber Altman ist natürlich nicht alleine: Der wirkliche Nutzen, Arbeitskräfte durch LLMs zu ersetzen, wird sich erst noch je nach Büroarbeiter-Branche erweisen. Was diverse Unternehmen nicht daran hindern wird, Personalabbau jeglicher Art mit der Perspektive der Automatisierung zu begründen. Und auch hier wird natürlich der Konkurrenzfaktor ein zentrales Argument sein - wie gesagt, unabhängig davon, ob LLMs in den jeweiligen Bereichen wirklich einen Mehrwert bieten.

Unter diesem Blickwinkel muss man auch den Streik der Hollywood-Autoren sehen. Ein Gewerkschaftsvertreter sagt der New York Times mit Bezug auf die verstorbene Drehbuchautorin Norah Ephron (Schlaflos in Seattle, Harry & Sally):

“Early on in the conversations with the guild, we talked about what I call the Nora Ephron problem. Which is basically: What happens if you feed all of Nora Ephron’s scripts into a system and generate an A.I. that can create a Nora Ephron-sounding script?”

Einige Forderungen sind in diesem Zusammenhang sinnvoll - zum Beispiel, dass Chatbots keine Drehbücher umschreiben dürfen. Andere wiederum weltfremd - so das Verbot, auf Chatbot-Output basierende Geschichten zu Drehbüchern zu machen. Und doch bleibt das Gefühl der Vergeblichkeit, dieser Entwicklung irgendwelche langfristigen Leitplanken zu geben. Womit ich im Resultat näher an der Haltung Sam Altmans bin, als ich mir eigentlich eingestehen möchte.

Chatbots - die falsche Benutzeroberfläche?

Werden wir wirklich dauerhaft per Chat mit Large Language Models (LLMs) kommunizieren? Amelia Wattenberger sagt: Nein. Beziehungsweise: Sie kritisiert Chatbots als völlig ungeeignete Nutzeroberfläche.

“The only clue we receive is that we should type characters into the textbox. The interface looks the same as a Google search box, a login form, and a credit card field. Of course, users can learn over time what prompts work well and which don't, but the burden to learn what works still lies with every single user. When it could instead be baked into the interface.”

Wenn man genauer darüber nachdenkt, ist ein reiner Chatbot eigentlich gar keine Nutzeroberfläche. Oder anders ausgedrückt: Es sind diverse Möglichkeiten denkbar, wie ein User Interface (UI) darüber gelegt werden könnte.

Die offensichtlichste UI ist natürlich angesichts der Dialoge die Stimme als 1:1-Übertragung. Aber im Assistenzkontext ließen sich auch Systeme denken, die auf dem UI erscheinen und Handlungsoptionen geben.

Allerdings eröffnet Wattenberger noch ein weiteres Feld: Nämlich die Frage nach dem grundsätzlichen Verhältnis von Mensch und Maschine.

“Automating tasks is going to be amazing for rote, straightforward work that requires no human input. But if those tasks can only be partially automated, the interface is going to be crucial.

I want to see more tools and fewer operated machines - we should be embracing our humanity instead of blindly improving efficiency. And that involves using our new AI technology in more deft ways than generating more content for humans to evaluate. I believe the real game changers are going to have very little to do with plain content generation. Let's build tools that offer suggestions to help us gain clarity in our thinking, let us sculpt prose like clay by manipulating geometry in the latent space, and chain models under the hood to let us move objects (instead of pixels) in a video.”

Eine sehr menschenzentrierte Vision von Technologie also, die im UX-Bereich zwar oft proklamiert, aber selten realisiert wird.

Der Vertrauensverlust

Ein anonymer Meta-Mitarbeiter in der Washington Post über die sinkende Moral in der Firma:

“What was special about Meta was the trust. We drank the Kool-Aid and really felt like it was our company [and] even willingly defended it when everyone said we were evil incarnate. But that’s been shattered, so it feels like a betrayal.”

Eine klassische Silicon-Valley-Geschichte, in dieser Version für Interessierte an Zuckerbergs Führungsstil definitiv interessant.

Links

OpenAI hat nach der jüngsten Investment-Runde einen Papierwert von 27 bis 30 Milliarden US-Dollar.

Europaparlamentarier einigen sich auf eine gemeinsame Verhandlungsposition zum “AI Act”.

Twitter leistet unter Musk häufiger Regierungsanfragen Folge also zuvor.

Bluesky-Hype in den US-Techmedien.

Ein KI-Künstler erklärt seinen Workflow.

Geschäftsmodelle für LLM-Chatbots.

Content-Farming erhält den KI-Boost.

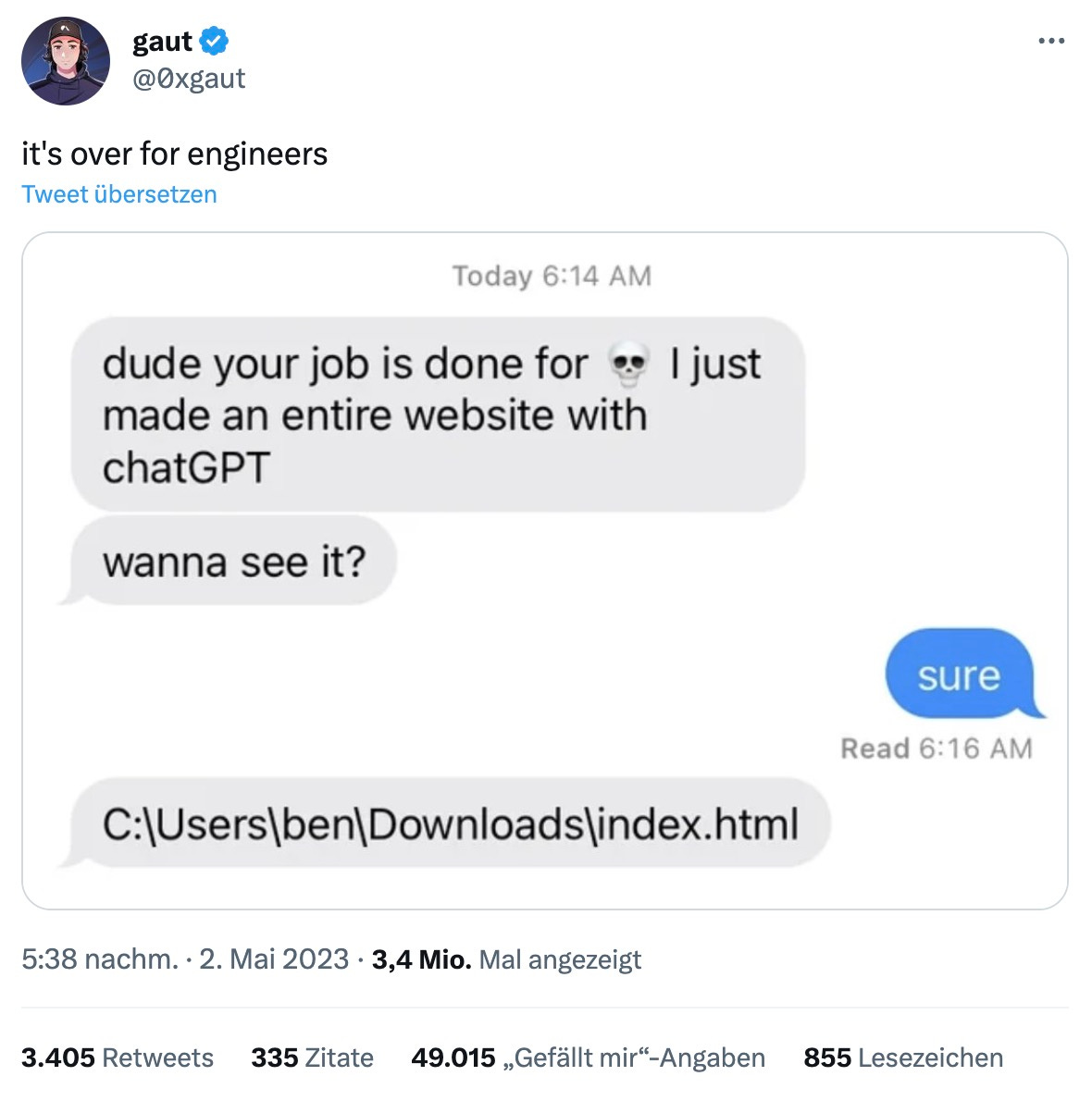

1 Shitpost

(Link)

Bis nächste Woche!

Johannes