Aus dem Internet-Observatorium #130

Verzeichnis kognitiver Verluste / KI-Müll und der wachsende Druck auf die Online-Realität

Hallo zu einer neuen Ausgabe! Ein Hinweis: In der kommenden Woche macht dieser Newsletter eine Pause.

Verzeichnis kognitiver Verluste

Die fortschreitende Technologisierung verändert unsere kognitiven Fähigkeiten. Wer darüber lamentiert, nimmt schnell die Rolle von Grandpa Simpson in obigem Meme ein: als alter Mensch, der die Wolken beschimpft. Passiert ja eh.

Denn was bedeutet der Verlust unseres Orientierungssinns durch GPS-Navigation im Vergleich zu dem Vorzug, im Autobahn-Geflecht von NRW die richtige Ausfahrt zu nehmen, ohne nebenbei panisch auf eine Papierkarte glotzen zu müssen? Oder hat uns Google wirklich “dumm gemacht”, wie der Technologiekritiker Nicolas Carr im Jahr 2008 mutmaßte? Der Taschenrechner den Fortschritt in der Mathematik zum Erliegen gebracht? Und sind unsere vernetzten Computer nicht vor allem Werkzeuge, die es klug zu nutzen gilt?

Die Antwort lautet: Ja, aber…

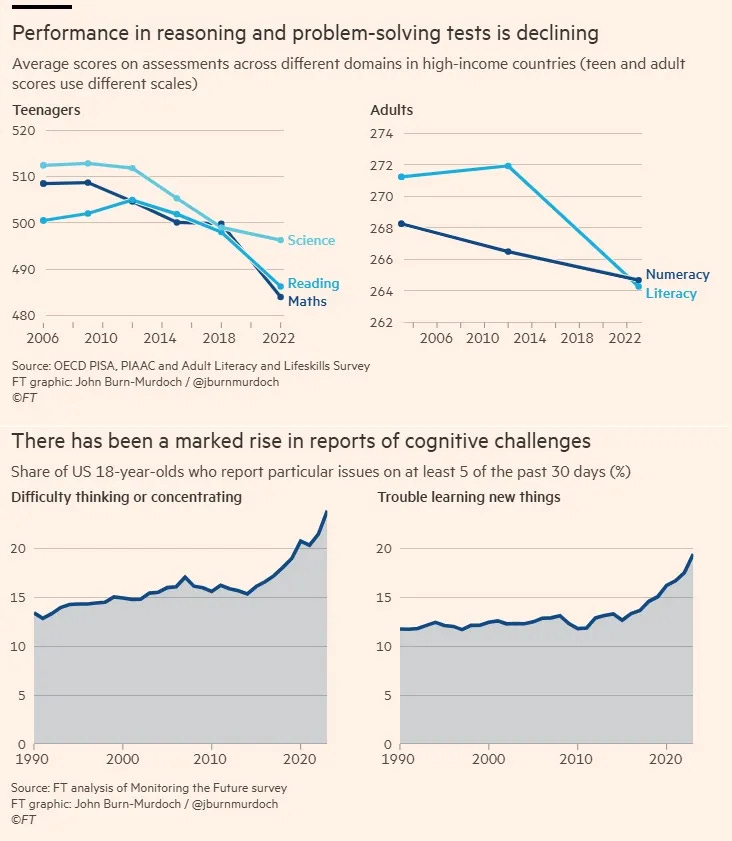

So fragt der Daten-Kolumnist John Burn-Murdoch in der FT, ob wir Menschen vor ein paar Jahren das Maximum unserer Hirnleistung erreicht haben und sie seitdem zurückgeht. Er zieht dafür einige Zahlen heran.

So sind seit 2012 die Ergebnisse im logischen Denken und im Problemlösen in den Benchmark-Tests der reichen Länder drastisch gesunken. Der Anteil der 18-Jährigen, in den USA die über Denk- und Konzentrationsschwierigkeiten berichten, ist seit Mitte der 2010er Jahre stetig gestiegen. 2022 gaben erstmals mehr als die Hälfte aller US-Amerikaner an, innerhalb eines Jahres kein Buch gelesen zu haben. Und 25 Prozent der Erwachsenen in einkommensstarken Ländern (und sogar 35 Prozent in den USA) gelingt es nicht, mathematische Grundlogik anzuwenden, wenn sie den Wahrheitsgehalt einer relativ einfachen Aussage überprüfen.

Die zugehörige Grafik:

Burn-Murdoch vermutet allerdings, und hier kommt der Plot-Twist, gar nicht an einen Rückgang unserer Hirnleistung, sondern an eine “Erosion” der menschlichen Fähigkeit, sich zu konzentrieren und sein Gehirn mit komplexen Fragestellungen zu konfrontieren. Kurz gesagt: Wir verarbeiten inzwischen Informationen anders als vorher. Passiver. Oberflächlicher.

So schreibt er in einem X-Thread zu seinem Artikel (übersetzt und gefettet):

“Die meisten Diskussionen über die gesellschaftlichen Auswirkungen digitaler Medien konzentrieren sich auf den Aufstieg von Smartphones und sozialen Medien, aber ich denke, das ist gleichzeitig eine unvollständige Erklärung und eine, die die gutartige/positive Nutzung digitaler Technologien mit der problematischeren in einen Topf wirft.

Ich würde auf etwas Grundlegenderes hinweisen: eine Veränderung der Beziehung zwischen unseren Gehirnen und Informationen. Die Art und Weise, wie wir Smartphones und soziale Medien Anfang der 2010er Jahre nutzten, war anders als heute. Die Nutzung war weitgehend aktiv und selbstbestimmt. Sie haben immer noch Ihr Gehirn eingeschaltet.

Aber seither hat sich einiges getan:

Der Übergang vom Social Graph (eine Auswahl an Inhalten von Menschen, die man kennt und mit denen man sich aktiv auseinandersetzt) zu Algorithmen (eine unendliche Flut der interessantesten Inhalte der Welt, mit viel weniger aktiver Beteiligung).

Der Übergang von Artikeln (längeres Material, das vom Leser eine Synthese, Schlussfolgerungen und Reflexion verlangt) zu kurzen, in sich geschlossenen Beiträgen (alles ist in wenigen Sätzen verpackt, kein kritisches Denken erforderlich).

Eine explosionsartige Zunahme der Anzahl und Häufigkeit von Benachrichtigungen, von denen jede einzelne die Gefahr birgt, dass sie einen von dem ablenken, was man zuvor getan hat (oder einen Teil des Kopfes in Beschlag nehmen, selbst wenn man sie ignoriert)

Untersuchungen haben ergeben, dass die aktive, bewusste Nutzung digitaler Technologien oft harmlos oder sogar vorteilhaft ist. Passive Nutzung und Unterbrechungen werden jedoch mit negativen Auswirkungen auf alle Bereiche in Verbindung gebracht, von unserer Fähigkeit, verbale Informationen zu verarbeiten, bis hin zum Arbeitsgedächtnis und zur Selbstregulierung.

Dies würde mit der Tatsache übereinstimmen, dass wir nicht nur eine abnehmende Lese- und Schreibfähigkeit feststellen, sondern auch eine Verschlechterung in einer Reihe von Wissensbereichen sowie zunehmende Probleme mit der allgemeinen kognitiven Leistungsfähigkeit.”

Am Ende betont Burn-Murdoch, dass der Rückgang nicht universal ist, sondern Menschen unterschiedlich mit dem neuen Medienumfeld zurecht kommen. Und dass dieser Rückgang theoretisch reversibel ist. Denn die zugrundeliegende Gehirnleistung sei weiterhin vorhanden.

Aber bewegen wir uns in diese Richtung? Ich musste bei dem Artikel an die Studie von Microsoft-Forschern in Zusammenarbeit mit einem Wissenschaftler von der Carnegie Mellon University denken, die im Januar veröffentlicht wurde.

Für diese Studie hatten die Forscher 319 Wissensarbeiter darüber befragt, wie sie KI einsetzen. Zum Beispiel einen Lehrer, der mit Dall-E Händewasch-Anleitungen erstellt; einen Marketing-Menschen, der seine Präsentationen mit Hilfe von KI erstellt; Künstler, die beim Brainstorming für Konzepte Chatbots zur Hilfe nehmen; Juristen, die sich bei der Formulierung von Dokumenten helfen lassen.

Das Resultat: Wer der KI vertraute, übernahm die Output-Ergebnisse oft ungeprüft. Übersetztes Zitat aus dem Paper (Fettungen meine):

“Überraschenderweise kann KI zwar die Effizienz steigern, aber auch die kritische Auseinandersetzung reduzieren, insbesondere bei Routineaufgaben oder Aufgaben, bei denen sich die Nutzer einfach auf die KI verlassen. Das eröffnet Bedenken hinsichtlich langfristiger Abhängigkeit und vermindertem unabhängigen Problemlösungsverhalten.”

KI hat einen negativen Einfluss auf das kritische Denken, heißt es sinngemäß an einer Stelle. Und: “Die Daten zeigen eine Verschiebung des kognitiven Aufwands, da sich die Aufgabe von Wissensarbeitern durch die Nutzung von generativer KI zunehmend vom Ausführen von Aufgaben hin zu einer Beaufsichtigung entwickelt.”

Warum macht mir die Synthese aus Burn-Murdochs These und der Microsoft-Studie Sorgen? Weil ich hier einen problematischen Kreislauf sehe: Die passive Rezeption technologisch kuratierter Inhalte – etwa in Social Media oder durch KI – führt zu kognitiver Verarmung, da Denkprozesse zunehmend oberflächlich werden.

KI führt dabei zwar zu Effizienzgewinnen (z. B. bei der Generierung von Code), aber die unkritische Nutzung führt zu einer weiteren kognitiven Verarmung. Doch wenn unsere eigene Fähigkeit zum Problemlösen weiter schrumpft, fördert dies eine wachsende Abhängigkeit von KI-Systemen. Undsoweiter. Ein negativer Kreislauf also - bei dem ich noch gar nicht die Möglichkeit epistemischer und ideologischer Manipulation durch KI-Systeme oder die von ihnen verursachte informationelle Verschmutzung durch Halluzinationen und Deepfakes eingepreist habe.

Ich sehe derzeit nicht, dass wir die technologischen Entwicklungen in Relation zum Verlust kognitiver Leistungsfähigkeiten setzen und strategische Gegenmaßnahmen ergreifen, kritisches Denken und die menschliche Fähigkeit zur Problemlösung zu bewahren. Das würde selbst dann nicht schaden, wenn die von mir gezeichnete Entwicklung nicht in dieser Form eintreten würde.

Nun ließe sich sich das als technikskeptische Folklore abtun, die ich hier von mir gebe. Aber KI ist kein Taschenrechner.

Naiv ist vielmehr der Vorschlag der Microsoft-Forscher, KI-Antworten mit einem Hinweis auf kritische Überprüfung zu versehen, um so das Nachdenken der Nutzer und Nutzerinnen in Gang zu setzen. Das erscheint mir ungefähr so wirksam wie der Nutri-Score auf Lebensmitteln.

KI-Müll als Angriff auf die Online-Realität

Vielleicht durchaus auch im Zusammenhang mit obigem Thema zu lesen…

Jason Koebler von 404 Media ist der wohl beste Journalist in Sachen AI Slop (siehe auch Ausgabe #93). Und das KI-Müll (wörtlich “KI-Klärschlamm”), also massenhaft produzierte KI-Bilder und -Videos ohne größeren Inhalt, ein wachsendes Problem sind, ist auf den sozialen Kurzvideo-Plattformen durchaus wahrzunehmen.

In seinem jüngsten Artikel beschreibt Koebler AI Slop als Brute-Force-Angriff auf die Auswahl der Algorithmen und damit auch auf unsere Online-Realität. Die schiere Menge an KI-Inhalten führt dazu, dass menschlich erzeugte Inhalte in den Hintergrund gedrängt werden. Die Plattformen haben keinen Grund, das einzudämmen: Den Endnutzern ist es offenbar letztlich egal, die Plattformen bieten selbst Tools für KI-Content an (z.B. Meta für KI-Werbeanzeigen) und am Ende ist KI-Content billiger Content.

Eine Stärke von Koeblers Recherche ist, dass er Verbindung zu diversen Akteuren pflegt, die solche Inhalte (in diesem Falle Kurzvideos) produzieren. Zwei davon kommen auch zu Wort (übersetzt und gefettet):

“Mustafa empfiehlt die “traurige Hotdog-Methode”, um viral zu werden, und vergleicht sowohl die Algorithmen der sozialen Medien als auch die Nutzer mit hungrigen Menschen, die um 2 Uhr morgens zu 7-Eleven gehen und etwas zu essen suchen: „Wenn man um 2 Uhr nachts hungrig ist, schmeckt sogar ein traurig aussehender Hotdog BESSER als jedes Michelin-Gericht, von dem man nur 2 Bissen bekommt. Nun, TikTok funktioniert in etwa auf die gleiche Weise.

Dein Publikum erwartet (oder will) keine perfekt polierten Videos. Wann haben Sie das letzte Mal ein virales TikTok-Video gesehen und gedacht: 'Wow, die Farbabstufung ist unglaublich!' Niemals. Weil es niemanden interessiert. Und das ist eigentlich eine gute Nachricht für Sie, denn das bedeutet, dass Sie Tausende verdienen können, wenn Sie sich auf die Quantität und NICHT auf die Qualität konzentrieren.”

Bitton vertritt unterdessen die “McDonald's-Theorie des YouTube-Erfolgs” und den “Tankstellen-Sushi”-Ansatz für Inhalte, die nahelegen, dass KI-Müll gut genug ist und dass Menschen, die Qualitätsvideos erstellen, ihre Zeit verschwenden und zum Scheitern verurteilt sind.”

Das Deprimierendste daran: Nothing matters. Content ist Content und an einigen Ecken der Aufmerksamkeitsökonomie dreht sich das Inhalte-Rad inzwischen nicht nur mit industrieller Geschwindigkeit, sondern fast vollautomatisiert. Und zwar nicht nur auf Seiten der Plattformen, sondern auch bei den Produzenten (siehe auch Ausgabe #89). Die Vision vom automatisierten Entertainment (siehe Ausgabe #69) wird konkreter, und wir kommen in diesem Zuge der Maschine immer näher.

Vorschläge für den “America action plan”

Während die Vereinten Nationen gerade eine Struktur für den anvisierten KI-Expertenrat zu finden versuchen, macht die wichtigste KI-Macht der Welt ihr eigenes Ding. Immerhin: Statt völliger Regelfreiheit hat die US-Regierung in den vergangenen Wochen zumindest Vorschläge zum künftigen Umgang mit Künstlicher Intelligenz eingesammelt.

Was dabei von den großen Anbietern kam, zeigt Interessen und Stoßrichtungen. So OpenAI hat einen Policy-Vorschlag veröffentlicht, in dem die Firma die bekannte Warnung wiederholt, dass China das KI-Rennen gewinnen könnte. Entsprechend soll die US-Regierung international Druck ausüben, um die Verbreitung chinesischer KI (lese: DeepSeek) zu verhindern. Um den KI-Standort USA voranzubringen, fordert man weitestgehende Deregulierung inklusive die explizite Erlaubnis, urheberrechtsgeschütztes Material als “Fair Use” verarbeiten zu können.

Zvi Mowshowitz schreibt dazu (übersetzt):

“Ihr Ziel ist es, dass die US-Regierung KI nicht nur darauf verzichtet, KI zu regulieren oder auf irgendeiner Ebene irgendwelche Auflagen zu machen, sondern auch dass man die Bundesstaaten daran hindert, dies zu tun.

Dabei soll Washington sicherstellen, dass bestehende Vorschriften nicht auf KI-Firmen anwendbar sind, indem man “Ausnahmen” aus geplanten Gesetzesentwürfen anstrebt, einschließlich der Befreiung von jeglicher Haftung. Die Firma betont dabei ausdrücklich die Immunität von Vorschriften, die insbesondere auf Foundation Models abzielen, und nennt SB 1047 [das kalifornische Gesetz zur KI-Regulierung, jk] als Beispiel dafür.

All das wird mit “Innovationsfreiheit” begründet, wobei OpenAI davor warnt, ansonsten Amerikas Führungsposition zu untergraben.”

Meta, dessen nicht-öffentliche Eingabe Casey Newton vorliegt, fordert ebenfalls Fair Use für das Einsaugen von digitaler Informationen. Auf DeepSeek verweist man, um für die eigenen Open-Source/Open-Weight-Architekturen zu werben: Ein mögliches amerikanisches Exportverbot für solche Modelle würde das Feld den Chinesen überlassen, so das Argument.

Google wiederum spricht sich für Exportkontrollen aus, allerdings nur in sehr begrenzten Bereichen. Besonders kritisch sieht man dagegen die von der Biden-Regierung eingeführten Nachweispflichten für Rechenzentren, welche Kunden hochtourige KI-Trainings fahren. In Sachen Regulierung fordert man erwartungsgemäß innovationsfreundliche Regeln auf Bundesebene (IMO um strengere bundesstaatliche Gesetz zu verhindern), eine Freistellung von Haftungsfragen sowie ein landesweites Privacy-Gesetz (IMO um zum Beispiel die kalifornischen Gesetze auszuhebeln).

Microsoft kritisiert die Regeln der Biden-Regierung ebenfalls - konkret fordert man, Länder wie Saudi-Arabien, Polen oder die Schweiz von einem Limit an Chip-Importen auszunehmen und wie “Tier-1-Ländern” (z.B. Deutschland) Vollzugriff zu geben. Und Anthropic wünscht sich neben 50 Gigawatt zusätzlicher Energie ab 2027 für die USA (nur für KI-Rechenzentren) von der Regierung auch, sich auf die Veränderungen des Arbeitsmarkts durch KI-Verbreitung vorzubreiten.

Weitere Eingaben: Foundation for American Innovation, Authors Alliance, ARC Prize Foundation, Future of Life Institute, Internet Works, News Media Alliance, the Association of American Publishers, American National Standards Institute, Business Software Alliance, the Securities Industry and Financial Markets Association, the Center for AI and Digital Policy, a16z, the Center for Data Innovation, R Street Institute, the Abundance Institute, .

Eine ausführlichere Zusammenfassung hat Fortune.com.

Notizen

Bücher im Gespräch: Sarah Wynn-Williams: Careless People Das Enthüllungsbuch einer erweiterten Meta-Führungskraft macht auch deshalb Schlagzeilen, weil Meta die Veröffentlichung verhindern und die geschilderte Verantwortungslosigkeit relativieren möchte (mehr im Social Media Watch Blog, €). Ex-Meta-Mitarbeiterin Katie Harbath hält die Schilderungen für übertrieben; politisch interessant ist der Versuch Zuckerbergs, Facebook nach China zu bringen, auch wenn dies Zensur und Überwachung bedeutet hätte, sowie die Backstage-Absprachen mit der irischen Regierung, die sich offiziell kritisch gab, tatsächlich aber Meta den Rücken freihielt.

Community Notes: Bloomberg hat vor dem Rollout von Community Notes bei Meta die Wirksamkeit solcher Nutzeranmerkungen bei X analysiert. Das Resultat: Positiv ist, dass die Notes schneller als reguläre Faktenchecks funktionieren. Negativ: Bei kontroversen Themen gibt es oft keine Einigung zwischen Nutzern, was zur Folge hat, dass selbst richtige Anmerkungen unsichtbar bleiben (z.B. Kritik an Elon Musk). Vor allem aber sind ein Drittel der Community Notes de facto verbale Formen des “Flaggings” - man hat also grundsätzliche Moderationsfunktionen einfach an die Nutzerschaft outgesourced. Der Weg zu einem besseren Diskussionsklima sei das nicht, so das Fazit.

Links

Huaweis EU-Bestechungsskandal: Was wir bisher wissen.

32 Milliarden US-Dollar: Alphabet kauft Cloud-Security-Anbieter Wiz.

DMA: EU-Kommission veröffentlicht Anweisungen zur Interoperabilität an Apple.

90 Firmen fordern EU-Kommission zum Bekenntnis zu europäischen Digitallösungen auf (vgl. EuroStack).

US-Wettbewerbsbehörde FTC löscht Kritik an Big Tech von der eigenen Webseite.

Amazons US-Kunden können künftig Echo nicht mehr daran hindern, Sprachdaten zu sammeln.

Baidu veröffentlicht neues KI-Modell “Ernie X1” ($)

BGH: Bundeskartellamt darf Apple stärker überwachen.

Telegram-Chef Durow verlässt Frankreich.

Ed Zitron: CoreWeave, das WeWork der KI-Blase?

KI-Suchmaschinen sind noch fehleranfälliger als gedacht.

Gemini Robotics liegt im Trend.

Trainingsdaten vergiften: Russische Versuche unerkannter Propaganda.

Deeptech in der EU - der aktuelle Stand.

Was der Westen von der Ukraine im Kampf um die Online-Narrative lernen kann.

Elon Musk und seine Geschäftsverbindungen nach China.

Norwegen, der unterschätzte Satelliten-Macht.

Vorschlag für eine europäische Medienplattform.

Neues Gemini-Anwendungsgebiet: Wasserzeichen aus Fotos entfernen.

Sex ohne Frauen: Über Online-Pornographie und Kapitalismus im Endstadium ($)

Noch eine Nakamoto-Theorie. ($)

Bis zur nächsten Ausgabe!

Johannes